E-Book-Deal im September: It’s Online-Marketing

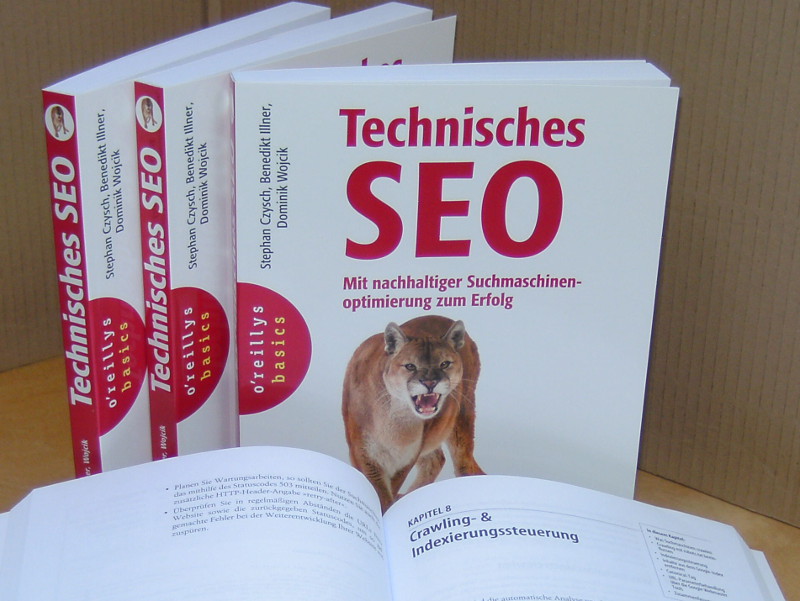

Wenn Busse und Bahnen gleichmäßig mit Kostüm- und SchlipsträgerInnen, mit Hipsterbärten und Jutebeuteln sowie mit Jeans-und-Hoodie-Freunden bevölkert sind, dann befindet Ihr Euch nicht (zwingend) in Berlin-Mitte. Ebenso möglich ist: Es ist Herbst, Ihr seid in Köln oder Hamburg und auf dem Weg zur dmexco oder NEXT. So unterschiedlich die beiden Events nämlich sind, es eint sie, dass sie einen – nämlich alle Menschen, die was mit dem Internet machen. (Und versuchen, damit Geld zu verdienen.) Auch wenn dabei gelegentlich Welten aufeinander prallen (nicht nur, was die Kleidungsfrage betrifft), so drehen sie sich um die digitale Welt, im Kleinen wie im Großen: Wie schafft man Vertrauen im Netz? Welche Tools eignen sich am besten zur Suchmaschinenoptimierung? Was kostet die digitale Transformation eines Unternehmens, und was kostet eine Google-Adwords-Anzeige? Einige dieser Antworten müssen wir uns alle gemeinsam erarbeiten. Einige andere können wir Euch liefern. Und das zum Sonderpreis :-) Weil nämlich September nicht nur der Monat ist, in dem sich Onliner an Rhein und Elbe (und anderswo) zum Austausch treffen, sondern auch der Monat, an dessen Ende unsere Neuerscheinungen „Der …